Tout savoir avec notre

Foire aux

questions

Faisons le point sur toutes vos questions.

Dans cette FAQ, nous vous expliquons les termes parfois techniques, notre méthodologie et surtout, comment nous construisons une collaboration forte avec vous.

« Optimiser son site », ça veut dire quoi ?

Optimiser son site, c’est l’adapter pour qu’il soit bien positionné sur les moteurs de recherche comme Google. Cela permet d’être plus visible en ligne et d’attirer plus de visiteurs.

En général, cela concerne surtout le SEO « On Page », c’est-à-dire tout ce qui se passe directement sur votre site (comme le contenu, les mots-clés, les balises, la structure, etc.). Le but est de rendre votre site facile à comprendre pour Google et les autres moteurs de recherche.

Si vous n’avez pas de connaissances en référencement ou en développement web, il est vivement recommandé de faire appel à un professionnel pour vous aider.

À quoi sert la balise Meta description ?

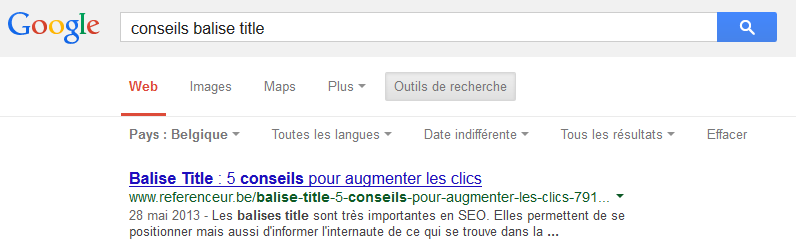

La balise Meta Description peut être considérée comme la petite soeur de la balise Title puisque, dans l’affichage des SERPs (Résultats des Moteurs de recherche ou Search Engine Page Result), elle figure juste en-dessous et permet de donner des informations plus précises à l’internaute concernant ce qui se trouve dans la page.

Dans l’exemple ci-dessus, la balise description est : « Les balises title sont très importantes en SEO. Elles permettent de se positionner mais aussi d’informer l’internaute de ce qui se trouve dans la page ».

Pour une bonne meta description, il faut que cette description soit en relation avec ce qui se trouve sur la page et il est préférable d’éviter les successions de mots clés pour ne pas être pénalisé par les moteurs de recherche.

À quoi sert la balise title ?

Chaque page d’un site internet comprend une balise « Title » (ou « Titre ») et d’après beaucoup de spécialistes en référencement, s’il ne fallait optimiser qu’un seul élément de son site internet, ce serait certainement le titre de ses pages.

Cette balise se présente sous cette forme : <title>Le titre de votre page</title> et s’affiche tout en haut de la page lorsque vous la consultez mais également sur les moteurs de recherche lorsque vous effectuez une recherche. C’est d’ailleurs la première chose que l’internaute voit lorsqu’il effectue sa recherche, il faut donc que cette balise soit attractive et donne envie de cliquer.

Dans l’exemple ci-dessous, la balise Title est la suivante : « Balise Title : 5 conseils pour augmenter les clics ».

Pour que la balise Title soit bien optimisée, il est important d’y inclure des mots clés (et synonymes), de les personnaliser et d’inciter l’internaute à cliquer dessus.

La longueur de cette balise ne doit pas dépasser 70 caractères en sachant que certains caractères sont plus gros que d’autres, ce qui influencera le nombre.

CMS : définition

CMS est l’acronyme de Content Management System, c’est-à-dire des systèmes de gestion de contenu. Il s’agit donc d’une famille de logiciels qui permettent de concevoir et de mettre à jour des sites internet ou des applications.

Il existe de nombreux CMS différents mais les plus connus sont WordPress, Joomla!, Drupal et Prestashop.

Combien de temps faut-il avant d’être bien positionné ?

Tout dépend de la stratégie de référencement mise sur pied. Avec du référencement publicitaire (AdWords), on positionne son site en 24 heures.

Pour le référencement naturel, il s’agit plutôt d’un travail de fond. Le site prendra plus de temps pour se positionner dans les résultats organiques. En temps normal, on considère qu’il faut environ trois mois pour bénéficier d’un bon référencement naturel.

Ce laps de temps dépend également du l’âge du site internet et de la concurrence sur le mot clé à positionner.

Comment augmenter le trafic d’un site internet ?

Il existe différents leviers qui permettent d’augmenter le trafic d’un site internet. Généralement, nous estimons que le meilleur moyen d’augmenter le trafic d’un site internet consiste à lever tous (ou une partie) de ces leviers en même temps.

Ces différents leviers sont le référencement naturel, les campagnes AdWords, les médias sociaux ainsi que les campagnes e-mailing. Avec une telle stratégie mise en place, il est inévitable de voir son site web gagner en visibilité !

Comment augmenter les ventes d’un site internet ?

Pour accroître les ventes en ligne, il est essentiel de générer davantage de trafic qualifié vers les pages produits. Cela passe par une amélioration de la visibilité du site sur les moteurs de recherche, à travers des actions SEO et/ou SEA. Il est important de cibler à la fois des requêtes générales et des recherches plus spécifiques, dites de longue traîne, qui attirent des internautes déjà en phase d’intention d’achat.

Lorsque les produits proposés sont compétitifs en termes de prix et de qualité, et qu’ils sont exposés à une audience pertinente, les ventes ont toutes les chances de progresser de manière régulière.

Comment bien choisir son nom de domaine ?

Le choix d’un nom de domaine n’est pas toujours aisé mais cela reste une étape essentielle dans le processus de création du site internet et de la notoriété de la marque.

Parmi les éléments auxquels il faudra prêter attention, on notera:

- L’extension du nom de domaine : à choisir en fonction de la portée souhaitée du site internet (utiliser le .com, .net ou .eu pour une portée internationale et le .be ou le .fr pour une portée nationale).

- L’insertion du nom de la marque dans le nom de domaine : un choix extrêmement important afin de pouvoir travailler le branding.

- La question de l’insertion d’un mot clé en plus de la marque dans le nom de domaine : une solution à analyser en fonction des besoins, du secteur d’activité et de la pertinence du nom de domaine.

Comment être visible sur Google ?

Pour être visible sur Google, il est nécessaire de proposer du contenu intéressant aux internautes, d’optimiser son site internet pour les moteurs de recherche mais également de mettre en place une stratégie de link-building efficace dans le but de rendre votre site internet populaire.

Comment indiquer aux moteurs de recherche de ne pas indexer certaines pages d’un site internet ?

De nombreuses raisons peuvent pousser une entreprise à empêcher l’indexation d’une page ou d’un répertoire de son site internet. Parmi celles-ci, on trouve les pages qui sont trop pauvres et qui peuvent avoir des conséquences négatives (Google Panda par exemple), les fichiers PDF qui sont identiques à certaines pages du site, les pages dupliquées, etc.

Pour indiquer aux moteurs de recherche qu’ils ne doivent pas prendre en compte ces pages, plusieurs solutions sont possibles:

- L’utilisation de la balise meta noindex : à insérer dans la balise de la page sous la forme <meta name=«robots» content=«noidex»

- Les en-têtes HTTP : pour empêcher l’indexation d’un répertoire complet, utilisez le fichier .htaccess (par exemple, insérer ceci dans le répertoire concerné : Header set X-Robots-Tag « noindex »)

- Le fichier robot.txt : par exemple: [User-agent: * Disallow: /ref ] aura pour effet de demander aux robots de ne pas visiter les adresses commençant par /ref

Comment optimiser son site web ?

Pour qu’un site soit bien compris par les moteurs de recherche, il est important de l’optimiser de manière adéquate. Parmi les éléments à optimiser : les métadonnées, le contenu, l’autorité, les performances ou encore les canaux secondaires.

Attention : il ne faut pas chercher à optimiser son site web de manière radicale pour les moteurs de recherche car Google peut le détecter et pénaliser le site en question.

Comment référencer un site en flash sur Google ?

Les sites internet créés en Flash (une technologie créée par Adobe qui permet notamment de créer des lecteurs audio, des lecteurs vidéos, des bannières animées, des sites internet, etc.) posent encore de gros problèmes au niveau du référencement sur Google car le moteur de recherche ne parvient pas à lire ce contenu car il n’y a pas de code source et le contenu n’est pas balisé (contrairement à celui réalisé en HTML).

En d’autres mots, cela signifie qu’un site entièrement réalisé en Flash passera inaperçu aux yeux de Google qui ne pourra l’indexer de manière idéale même si des progrès ont été réalisés dans le domaine ces dernières années.

Plutôt que le Flash, on utilisera donc le HTML pour mettre toutes les chances de son côté et s’assurer que son site soit bien référencé sur Google !

Crawler un site, ça veut dire quoi ?

Un crawler (ou robot d’exploration) est un programme informatique utilisé par les moteurs de recherche pour parcourir automatiquement les sites web. Son rôle est d’explorer les pages, d’en analyser le contenu (textes, images, vidéos, liens, etc.) et de les indexer afin qu’elles puissent apparaître dans les résultats de recherche.

Le terme « crawler » vient de l’anglais to crawl, qui signifie « ramper », en référence à la manière dont ce robot se déplace de lien en lien à travers le web. En 2013, il a été officiellement traduit en français par le mot collecteur, bien que le terme anglais reste largement utilisé.

Définition : le cloaking

Google l’explique très clairement dans son Centre d’aide : le cloaking (ou « dissimulation » en français) est une technique trompeuse qui peut entraîner des sanctions. Elle consiste à montrer un contenu différent aux utilisateurs et aux moteurs de recherche. Par exemple, un site peut afficher une page bien optimisée avec du texte aux robots de Google, tout en montrant une version totalement différente (comme une animation en Flash) aux visiteurs humains.

Cette pratique est considérée comme une tentative de manipulation du classement dans les résultats de recherche, et Google peut pénaliser un site qui l’utilise.

Définition : le clustering

Le clustering, en SEO, est une technique utilisée par les moteurs de recherche comme Google pour éviter qu’un seul site occupe trop de place dans les résultats d’une même recherche.

Concrètement, cela signifie que Google limite généralement à deux le nombre de pages affichées provenant d’un même site dans sa page de résultats. L’objectif est de diversifier les sources proposées aux internautes et d’offrir une expérience plus riche et équilibrée.

Cependant, si un site contient plusieurs pages pertinentes sur un sujet, Google peut parfois proposer un lien intitulé « Plus de résultats », permettant d’afficher davantage de pages issues de ce même site.

Définition : le duplicate content (contenu dupliqué)

Le contenu dupliqué (duplicate content en anglais) désigne une stratégie de référencement devenue pénalisante au fil du temps qui consistait à copier du contenu provenant d’un site internet concurrent.

Google pénalise aujourd’hui les contenus dupliqués afin de lutter contre le plagiat. La page incriminée est alors déclassée du moteur de recherche.

C’est essentiellement grâce au filtre Google Panda que le moteur de recherche est parvenu à lutter efficacement contre cette stratégie particulièrement spammy.

Définition : les in-depth articles (articles de fond)

Les In-Depth Articles, ou articles de fond en français, sont des contenus mis en avant dans les résultats de recherche de Google pour leur qualité élevée et leur approche approfondie d’un sujet.

Ces articles sont généralement identifiés par les algorithmes de Google, qui détectent les signaux de qualité et de pertinence. Toutefois, il est possible de faciliter cette reconnaissance en utilisant le balisage sémantique Article de Schema.org. Ce balisage aide les moteurs de recherche à mieux comprendre la nature et la qualité du contenu, augmentant ainsi ses chances d’être valorisé dans les résultats.

Définition : les rich snippets (extraits enrichis)

Les rich snippets (qu’on appelle en français extraits enrichis) correspondent à un certain nombre de données que le moteur de recherche de Google parvient à récupérer sur votre site afin de l’insérer dans ses résultats. Parmi ces informations, on peut trouver les prix des produits, des informations sur l’auteur, des avis de consommateurs, du maillage interne, etc.

En général, les rich snippets sont insérés dans les SERP afin d’enrichir l’expérience de l’internaute et de se démarquer de la concurrence.

Pour bénéficier des rich snippets, il convient d’optimiser la structure HTML du site internet ou de la page en question.

Définition : lien nofollow

L’attribut nofollow permet d’indiquer aux moteurs de recherche qu’un lien ne doit pas transmettre d’autorité (ou « jus de lien ») à la page vers laquelle il pointe. En d’autres termes, le lien est ignoré dans le calcul du référencement.

Un lien avec cet attribut ressemble à ceci :

<a href= »https://referenceur.be » rel= »nofollow »>ancre du lien</a>

Créé par Google en 2005, le nofollow a été conçu pour lutter contre le spam, notamment dans les commentaires de blogs, où certains tentaient de manipuler les résultats de recherche en déposant des liens artificiels. Depuis, il est largement utilisé pour éviter de cautionner ou de promouvoir des contenus externes non vérifiés ou non désirés.

Définition : un site miroir

Dans le domaine du référencement et du web, un site miroir désigne une copie exacte d’un autre site internet sous une adresse IP différente et sur plusieurs serveurs. Cette solution est utile pour les sites qui détiennent une forte demande au niveau international car cela permet de répartir la charge sur différents serveurs.

Cependant, s’ils peuvent être utiles dans certaines situations, les sites miroirs sont aujourd’hui mal vus par les moteurs de recherche car il s’agit d’une forme de duplication de contenu. Cette technique fonctionnait auparavant comme technique de référencement mais est aujourd’hui complètement obsolète.

Définition du fichier SiteMap

Le fichier SiteMap désigne un fichier en format XML qui liste les pages d’un site internet pour qu’elles soient toutes prises en compte par les moteurs de recherche. Ce fichier permet aussi aux moteurs de recherche d’analyser plus rapidement les pages d’un site web.

Créé au départ par Google, le fichier sitemap est aujourd’hui utilisé par tous les moteurs de recherche. Il est généralement placé à la racine du site.

Définition du fil d’ariane

Le fil d’Ariane (en anglais, on utilise le terme « breadcrumb ») permet de hiérarchiser un site internet et d’en faciliter la navigation. Situé en général au-dessus du contenu de la page, il permet de visualiser l’endroit où on se situe sur le site internet et d’atteindre d’autres catégorisations d’un simple clic.

Voici un exemple de fil d’Ariane : Accueil > Voiture > Location > Ford

L’utilisation du fil d’Ariane est très pertinente car il permet aux internautes de savoir où ils se trouvent sur le site internet, il permet d’accéder directement à d’autres pages et il améliore le référencement via le maillage interne du site internet.

Faut-il avoir un blog pour faire du référencement ?

Tenir un blog à jour de façon régulière, en publiant des actualités, des conseils ou des contenus informatifs à destination de ses clients potentiels, n’est pas une obligation en référencement naturel. Toutefois, cette stratégie reste fortement recommandée, car elle permet de garder le site actif, d’apporter du contenu pertinent aux internautes, et de renforcer l’image de marque ainsi que l’expertise de l’entreprise dans son domaine.

Les moteurs de recherche, et en particulier Google, mettent toujours davantage l’accent sur la qualité, la pertinence et la fraîcheur des contenus. Un blog mis à jour régulièrement facilite le respect de ces critères et améliore ainsi la visibilité du site. Il permet aussi de travailler un plus grand nombre de mots-clés, d’attirer du trafic sur des sujets connexes à votre activité, et de favoriser le partage naturel de vos contenus.

Faut-il réécrire ses URL pour un meilleur référencement ?

Lorsqu’on travaille sur le référencement d’un site web, le format des URL mérite une attention particulière dès le départ. En effet, Google valorise l’ancienneté des pages, et toute modification d’URL peut entraîner une perte significative, voire totale, de leur positionnement dans les résultats de recherche.

Si une modification d’URL s’avère incontournable, par exemple lors d’un changement de nom de domaine, il est essentiel de mettre en place une redirection permanente (301). Celle-ci permettra de conserver la popularité acquise par la page et d’assurer une transition fluide pour les utilisateurs comme pour les moteurs de recherche.

Ainsi, la réécriture des URL doit être abordée avec rigueur et stratégie, afin de préserver, voire améliorer, la visibilité du site sur les moteurs de recherche.

Faut-il se concentrer uniquement sur Google pour le référencement ?

En 2025, Google reste largement dominant dans le domaine des moteurs de recherche, en particulier en Europe et dans de nombreuses régions du monde. Il détient encore plus de 90 % des parts de marché dans des pays comme la France, la Belgique, la Suisse, l’Espagne, l’Allemagne ou encore le Brésil. Dans ces contextes, il est logique de prioriser le référencement sur Google, car c’est là que se trouve l’écrasante majorité du trafic potentiel.

Cependant, il ne faut pas ignorer les alternatives lorsque votre stratégie vise des marchés spécifiques, ou si vous ciblez des audiences aux comportements numériques différents. Voici quelques moteurs de recherche qui conservent une importance stratégique selon les zones géographiques :

- Bing : vvec l’intégration poussée de l’IA via Microsoft (notamment Copilot et son partenariat avec OpenAI), Bing a regagné une part d’intérêt, notamment aux États-Unis, dans certains secteurs B2B et via ses intégrations dans Windows.

- Yahoo : bien que son influence ait fortement diminué, il utilise encore la technologie de Bing, et peut apporter un trafic marginal selon le public ciblé.

- DuckDuckGo : de plus en plus populaire auprès des utilisateurs soucieux de leur vie privée, principalement en Amérique du Nord et en Europe.

- Yandex : le moteur de recherche dominant en Russie, bien que son usage international soit limité.

- Baidu : le moteur principal en Chine, incontournable si vous ciblez le marché chinois, qui reste très fermé à Google.

- 360 Search (ou So.com) : une alternative également populaire en Chine, surtout dans certains segments du web local.

Faut-il un logiciel pour référencer son site ?

Non, il n’est pas nécessaire d’avoir un logiciel pour référencer son site internet. Mais, certains outils permettent d’aider le suivi du référencement, d’analyser les mots clés à positionner ou d’analyser le trafic de son site internet.

Attention cependant avec les logiciels car si certains offrent la possibilité de soumettre des liens à des annuaires et à des sites de communiqués de presse, cette stratégie peut se révéler très dangereuse à l’heure où les mises à jour de Google Penguin semblent de plus en plus sévères.

Faut-il utiliser des pages satellites pour son référencement ?

Il y a encore quelques années de cela, les pages satellites permettaient d’améliorer le référencement des sites internet dans les moteurs de recherche. Leur principe était relativement simple: créer des pages associées à une thématique et les lier au site internet principal dans le but d’accroître sa popularité.

Les moteurs de recherche considèrent cette pratique comme allant à l’encontre de leurs consignes et c’est pour cette raison que Google (notamment) a décidé de pénaliser les sites qui utilisaient encore des pages satellites pour améliorer leur référencement (via un déclassement ou une suppression complète des résultats de recherche).

Google Hummingbird, c’est quoi ?

A la fin du mois de septembre 2013, Google a annoncé la sortie d’un nouvel algorithme à l’occasion du 15ème anniversaire de son moteur de recherche. Le nom de ce nouvel algorithme : Hummingbird (ou Colibri).

L’objectif de ce nouvel algorithme : améliorer la pertinence des résultats fournis par les moteurs de recherche et « mieux répondre aux requêtes les plus complexes ». D’après de nombreux observateurs, ce nouvel algorithme devrait essentiellement impacter les recherches sur la longue traîne.

Google Panda, c’est quoi ?

Les algorithmes de Google sont régulièrement mis à jour par des filtres qui doivent permettre à Google d’offrir des meilleurs résultats de recherche aux internautes. Google Panda fait partie de ces filtres et est apparu pour la première fois en février 2011 pour les requêtes anglophones et en août 2011 (la version 2.3) pour les requêtes françaises.

L’objectif de Google Panda est simple puisque la mise à jour vise à pénaliser les sites internet qui :

- Sont sans valeur ajoutée pour les utilisateurs,

- Copient les contenus d’autres sites internet (duplicate content),

- Ne sont pas très utiles.

Jusqu’au début de l’année 2013, des mises à jour de Panda étaient effectuées presque tous les mois par Google mais Matt Cutts, le chef de l’équipe anti-spam de Google, a ensuite indiqué que ces mises à jour se feraient tous les mois pendant une dizaine de jours sans que cela ne soit indiqué par le moteur de recherche.

Google Payday Loan, c’est quoi ?

Lancé au mois de juin 2013, Google Payday Loan est un filtre antispam mis au point par Google afin de lutter contre les requêtes particulièrement spammy, c’est-à-dire celles qui proviennent du registre de la porn0graphie, des jeux, du viagra, des casinos ou encore de ce que les anglophones appellent le « Payday Loan » (qu’on pourrait traduire par « prêt sur salaire »).

Depuis le lancement de Google Payday Loan a été lancé en 2013, plusieurs actualisations du filtre ont été réalisées.

Google Penguin, c’est quoi ?

Un an après la première mise à jour de Google Panda, ce fût au tour de Google Penguin de voir le jour dès le mois d’avril 2012. Cette fois, il n’était pas question de viser le contenu des sites internet mais bien de pénaliser les pratiques externes que Google jugeait irrégulières et non-naturelles parmi lesquelles on trouvait des pratiques de netlinking abusives et des backlinks non-naturels.

Les mises à jour de Google Penguin auront été beaucoup moins régulières que celles de Panda puisqu’on a pu en dénombrer uniquement 6 depuis son lancement en avril 2012 (contre plus d’une vingtaine pour Google Panda).

Google Pigeon, c’est quoi ?

Lancé au mois de juillet 2014 aux Etats-Unis, Google Pigeon est un algorithme de Google qui a pour objectif de proposer des résultats plus pertinents et plus précis lorsque les internautes effectuent des recherches locales, c’est-à-dire les recherches ciblées géographiquement.

Après les Etats-Unis, cet algorithme s’est petit à petit déployé en Europe (notamment au Royaume-Uni), au Canada et en Australie afin d’apporter des améliorations au niveau de la correction orthographique, du Knowledge Graph ou encore de la gestion des synonymes (en plus de la pertinence des résultats de recherche géolocalisés).

Google Pirate, c’est quoi ?

Google Pirate est un filtre du moteur de recherche qui a été déployé au mois d’août 2012 puis mis à jour en octobre 2014. Ce filtre a pour objectif d’empêcher les sites qui enfreignent le droit d’auteur de se positionner dans les meilleurs résultats du moteur de recherche.

Parmi les sites qui ont été principalement touchés par les mises à jour, on trouve ceux qui figurent dans le système DMCA (Digital Millenium Copyright Act) ainsi que de nombreux sites de téléchargement illégal.

L’algorithme mobile-friendly : qu’est-ce que c’est ?

Le 21 avril 2015, Google a décidé de modifier son algorithme dans le but de rendre les résultats affichés sur smartphones plus pertinents. Pour ce faire, il a introduit un nouveau critère dans son algorithme mobile (le critère de compatibilité mobile) et les sites internet qui n’étaient pas adaptés pour smartphones ont perdu de la visibilité dans les résultats de recherche.

Cette modification de l’algorithme de Google n’a touché que les résultats affichés sur les smartphones et a été déployé directement mondialement.

L’attribut « ALT », ça sert à quoi ?

En référencement, l’attribut ‘Alt’ désigne un élément HTML qui permet aux moteurs de recherche de comprendre et d’indexer une image. On les retrouve sous la forme suivante dans le code source du site internet :

<img src= »# » alt= »L’attribut Alt: définition » />

La définition du SEO

Le SEO (Search Engine Optimization) permet d’optimiser la visibilité de votre site web sur les moteurs de recherche. Grâce à une stratégie sur mesure, nous vous aidons à améliorer votre positionnement et à attirer un trafic organique de qualité, pour des résultats durables.

La recherche universelle sur Google : définition

Déployée en mai 2007 par Google, la recherche universelle (Universal Search en anglais) désigne le concept qui permet aux internautes d’obtenir des réponses associées à des résultats verticaux ou à des services tiers.

La recherche universelle de Google comprend notamment des cartes, des images, des actualités, des extraits de livre, des résultats personnalisés, des résultats provenant des réseaux sociaux, des traductions, des vidéos, des définitions, des résultats sportifs, la météo, etc.

Google utilise parfois des rubriques particulières dans le cadre de la recherche universelle. Il s’agit notamment de Google Maps, de Google Images, de Google Actualités, de Youtube, etc.

Le black hat et le white hat : définitions

En référencement naturel (SEO), on distingue deux grandes approches :

Le white hat SEO (chapeau blanc) :

Cette méthode respecte les règles et recommandations de Google. Elle consiste à améliorer le positionnement d’un site de manière honnête et durable, en misant sur la qualité du contenu, la structure du site, l’expérience utilisateur, etc.

Le black hat SEO (chapeau noir) :

Cette approche utilise des techniques plus agressives ou trompeuses, souvent contraires aux consignes de Google (comme le bourrage de mots-clés ou l’achat massif de liens). Bien qu’elle puisse générer des résultats rapides, elle expose fortement le site à des sanctions de la part des moteurs de recherche, pouvant aller jusqu’à sa disparition totale des résultats pendant plusieurs mois.

Chez Référenceur, nous utilisons uniquement des techniques white hat, car elles sont plus sûres, plus stables et plus respectueuses des bonnes pratiques. Notre objectif est d’assurer un positionnement durable des sites web, sans prendre de risques inutiles qui pourraient compromettre leur visibilité à long terme.

Le fichier robots.txt : définition

Le fichier Robots.txt est un document texte qui se trouve à la racine de votre site internet et qui est utilisé par une grande majorité des moteurs de recherche pour indiquer aux robots ce qu’ils doivent et ce qu’ils ne doivent pas explorer.

Par convention, les robots des moteurs de recherche consultent toujours les fichiers robots.txt avant d’explorer les sites internet.

Le keywordstuffing (bourrage de mots clés) : définition

Le keywordstuffing est une technique parfois pratiquée par les référenceurs black hat pour duper les moteurs de recherche. Cette technique consiste à inclure un nombre important de mots clés non-pertinents dans les balises Title et Meta Description mais aussi dans le contenu de la page.

Cette pratique a été très répandue à un moment mais est beaucoup moins visible depuis que Google a lancé Google Panda pour lutter contre ce type de contenu. Le keywordstuffing diminue tellement l’expérience de l’internaute qu’il vaut mieux éviter de le pratiquer aujourd’hui, même en black hat.

Le Negative SEO : définition

Depuis que Google a commencé à pénaliser les sites web qui utilisent des techniques de création de liens contraires à ses règles (notamment avec sa mise à jour Google Penguin), certaines personnes mal intentionnées ont essayé de nuire à leurs concurrents. Pour cela, elles créent des centaines voire des milliers de liens de mauvaise qualité qui pointent vers le site de leur concurrent. Cette technique s’appelle le Negative SEO.

Pour lutter contre ces attaques et permettre aux sites victimes d’injustices de se défendre, Google a mis en place un outil spécial appelé outil de désaveu de liens. Il permet aux propriétaires de sites web de signaler à Google les liens douteux qu’ils ne souhaitent pas voir pris en compte.

Les algorithmes de Google, c’est quoi ?

Comme l’explique Google sur son site web, « les algorithmes sont des programmes informatiques conçus pour naviguer parmi des milliards de pages ». En effet, pour offrir des résultats qui répondent à la recherche effectuée, Google se sert d’algorithmes qui classent et répertorient les pages web.

Parmi les éléments (il y en a plus de 200) pris en compte par les algorithmes de Google on trouve : les termes figurants sur le site internet, le rafraîchissement du contenu du site web, la localisation ou encore le PageRank.

Les balises H1, H2, H3 etc. sont-elles importantes en référencement ?

Oui, les balises H1, H2, H3, etc. sont importantes en référencement.

Elles structurent le contenu d’une page web, facilitent la lecture pour les internautes et aident les moteurs de recherche à comprendre les sujets abordés.

La balise H1 indique le titre principal, tandis que les autres balisent les sous-sections. Une hiérarchie claire avec des mots-clés pertinents améliore la lisibilité et le référencement naturel.

Pourquoi désavouer des liens en référencement ?

Google considère généralement que si d’autres sites font des liens vers le vôtre, c’est un bon signe : cela montre que votre contenu est utile ou de qualité.

Mais parfois, des liens sont créés uniquement pour essayer de tromper Google, par exemple, via des réseaux de liens ou des liens achetés. Ces pratiques peuvent nuire à votre site et entraîner une pénalité dans les résultats de recherche.

Si vous remarquez des liens suspects pointant vers votre site, et que vous ne pouvez pas les faire supprimer directement (par exemple, en contactant le site concerné), vous pouvez utiliser l’outil de désaveu de liens. Cet outil permet de dire à Google :

« Je ne veux pas que ces liens soient pris en compte pour le référencement de mon site. »

Cela peut vous protéger d’une pénalité ou vous aider à en sortir si votre site a déjà été affecté.

Pour soumettre une liste de liens à désavouer, rendez-vous dans la Search Console de Google, sur la page dédiée à cet outil.

Qu’est-ce qu’un site internet responsive web design ?

Un site en Responsive Web Design (ou site adaptatif en français) ajuste automatiquement son affichage selon le type d’appareil utilisé : smartphone, tablette ou ordinateur. Cette adaptation, rendue possible grâce aux feuilles de style CSS, garantit une expérience utilisateur fluide et agréable, quel que soit le support.

Dans un contexte où Google prend en compte la compatibilité mobile dans ses critères de référencement, adopter le responsive est devenu indispensable pour être bien positionné et accessible sur tous les écrans.

Qu’est-ce qu’une balise canonical ?

La balise rel= « canonical » désigne une balise HTML qui permet d’informer les moteurs de recherche qu’une page similaire existe déjà ailleurs (sur une URL différente donc).

L’intérêt de cette balise réside dans le fait qu’elle permet de solutionner des problèmes de duplicate content.

La balise rel= « canonical » doit être insérée entre les tags de la page concernée.

Qu’est-ce que la longue traîne ?

La longue traîne (ou long tail en anglais) désigne une expression de recherche très précise, généralement composée de plusieurs mots. Même si ces expressions sont moins recherchées que des mots-clés plus génériques, elles attirent des visiteurs plus qualifiés sur un site, car elles répondent à un besoin très spécifique.

Par exemple :

Une recherche générique comme « jupe » est vague et peut renvoyer à toutes sortes de jupes.

Une requête de longue traîne comme « jupe rouge courte taille 36 » est beaucoup plus ciblée : la personne sait exactement ce qu’elle veut, ce qui augmente les chances qu’elle achète ou effectue une action sur le site.

En résumé : plus une recherche est précise, plus elle attire un public intéressé, et plus elle a de chances de générer des conversions (achats, inscriptions, etc.).

Qu’est-ce que le content spinning ?

Souvent utilisé dans le milieu du référencement black hat, le content spinning désigne une méthode qui permet de générer des textes différents de manière automatisée dans le but de gagner un temps précieux.

Dans les grandes lignes, ce procédé consiste à écrire un texte spécifique en proposant des variantes pour chaque mot (ou presque).

Voici un exemple concret : [La {voiture|moto|bicyclette} de {Thomas|Frédéric|Quentin} est {rouge|bleue|verte} et est à vendre en {excellent|bon} état de marche]

Grâce à un outil spécial de content spinning, cette phrase générera une multitude de textes différents en prenant au hasard les mots proposés.

Depuis la sortie de Google Panda, l’impact et l’efficacité du content spinning se sont fortement réduits, cette stratégie pouvant même être la cause de pénalités de la part du moteur de recherche.

Qu’est-ce que le knowledge graph ?

Le Knowledge Graph, annoncé par Google en mai 2012, est une base de connaissances destinée à fournir directement des informations pertinentes aux internautes, sans qu’ils aient besoin de quitter la page de résultats du moteur de recherche.

Cette base regroupe des données provenant de plusieurs sources fiables, telles que Wikipedia ou Freebase, et permet à Google d’afficher des réponses structurées et contextuelles, en lien avec les requêtes des utilisateurs.

Au fil du temps, Google continue d’enrichir le Knowledge Graph, dans le but de devenir un véritable moteur de réponses, capable de comprendre les relations entre les personnes, les lieux, les événements ou les objets.

Les résultats issus du Knowledge Graph sont accessibles sur tous les types d’appareils : ordinateurs, tablettes et smartphones, offrant ainsi une expérience utilisateur cohérente, quel que soit le support utilisé.

Qu’est-ce que le PageRank ?

Le PageRank est une valeur numérique variant entre 0 et 10 qui est associée par Google à tous les sites web afin de quantifier sa popularité. Le PageRank figure parmi les éléments qui servent à positionner les sites internet dans le moteur de recherche.

A l’heure actuelle, le PageRank n’est plus actualisé par Google (la dernière mise à jour date de 2013 et avait été effectuée par erreur). Il ne faut donc plus se fier à cet indicateur.

Qu’est-ce que le référencement SEO ?

Le référencement sur les moteurs de recherche consiste à positionner les sites internet le mieux possible sur des requêtes choisies au préalable en fonction du secteur d’activité (de l’entreprise, de la personne morale ou du site web).

Le référencement (ou SEO – Search Engine Optimization) consiste à mettre en place différentes techniques qui permettront à un site internet de se positionner dans les meilleurs résultats des recherches de Google (ou SERP).

Que signifie l’acronyme CTR ?

CTR signifie Click-Through Rate en anglais ou taux de clic en français. Il s’agit d’un indicateur qui permet de mesurer efficacement la performance d’une annonce lors d’une campagne publicitaire (sur Google AdWords par exemple).

Le taux de clic désigne le rapport entre le nombre de clics sur une annonce et le nombre d’affichages de l’annonce (x 100 pour obtenir le pourcentage). Par exemple, si une annonce est vue 100 fois et reçoit 5 clics, son taux de clics sera de 5 %.

Que signifie l’acronyme PPC/CPC ?

L’acronyme PPC désigne un mode de tarification signifiant Pay Per Click en anglais ou Coût par clic (CPC) en français. Principalement utilisé lors de campagnes publicitaires effectuées sur le web (et notamment sur Google AdWords), le PPC détermine le prix de l’enchère des clics des internautes sur une annonce. Plus le PPC maximum autorisé sera élevé, plus les chances de voir l’annonce se positionner au top seront grandes.

Que signifie l’acronyme UX ?

Le terme UX, abréviation de l’anglais User Experience, désigne l’expérience utilisateur, c’est-à-dire la manière dont une personne perçoit et vit l’interaction avec un produit, un service ou, dans notre cas, un site internet.

Dans le domaine du web, l’UX englobe plusieurs aspects essentiels, tels que :

- L’apparence visuelle et l’ergonomie du site

- La crédibilité perçue par l’utilisateur

- L’efficacité du site à répondre aux besoins

- La facilité de navigation et d’utilisation

- L’adaptabilité du site à différents supports (ordinateur, mobile, tablette)

- Et bien d’autres facteurs influençant la satisfaction globale

Que signifie SERP ?

SERP signifie en anglais Search Engine Results Page. Autrement dit, il s’agit de la page de résultats d’un moteur de recherche.

Redirection 301 : définition

Une redirection 301 est un code d’exécution présent dans l’en-tête d’une page pour indiquer au navigateur que le contenu de la page a changé d’URL. On utilise donc ce code lorsqu’on change le nom d’un site ou d’une page pour maintenir le trafic et la visibilité. Les internautes sont automatiquement redirigés vers la nouvelle URL grâce à ce type de redirection.

SEA, SEM, SEO, SMO : qu’est-ce que c’est ?

Les professionnels du référencement utilisent toute une série d’abréviations qui ne sont pas toujours compréhensibles pour les novices.

- Le SEO (Search Engine Optimization) désigne l’optimisation pour les moteurs de recherche, c’est-à-dire le référencement.

- Le SEA est le Search Engine Advertising, c’est-à-dire la publicité sur les moteurs de recherche. Chez nous, le SEA le plus connu est l’AdWords de Google qui permet d’afficher ses annonces dans les pages de résultats.

- SEM ou Search Engine Marketing est le marketing sur les moteurs de recherche. Cela consiste en toutes les techniques qui permettent de renforcer la visibilité d’un site internet sur le web. Aujourd’hui, le SEM ne se limite plus aux moteurs de recherche et s’est étendu aux réseaux sociaux.

- SMO ou Social Media Optimization est l’optimisation sur les réseaux sociaux. Cela comprend toutes les techniques qui permettent d’augmenter sa visibilité sur les réseaux sociaux. Cela concerne aussi bien la création de posts organiques que l’adaptation de la page Facebook en elle-même.

Suis-je indexé sur Google ?

Pour savoir si on est visible sur Google, on peut taper la commande « site:https://referenceur.be » dans la barre de recherche. Si vous voyez apparaître toutes les pages de votre site internet, cela veut dire que Google les reconnait et les identifie. Cependant, cela ne veut pas dire qu’on se positionnera dans les premiers résultats des recherches.

Un EMD : c’est quoi ? Et ça sert à quoi ?

Dans le jargon du référencement, l’acronyme EMD signifie Exact Match Domain. Il désigne un nom de domaine contenant exactement les mots-clés ciblés par une requête. Par exemple, le domaine voyage-pas-cher.com vise clairement à se positionner sur la recherche « voyage pas cher ».

Cependant, au fil des dernières années, Google a renforcé ses efforts pour pénaliser les EMD de faible qualité, dans le but d’assainir ses résultats de recherche en écartant les sites peu pertinents. En conséquence, l’impact des mots-clés présents dans un nom de domaine tend à diminuer.

Aujourd’hui, il est donc préférable d’éviter les EMD et de privilégier un nom de domaine basé sur votre marque, qui favorise une stratégie de référencement plus durable et une meilleure image à long terme.

Une page d’atterrissage (ou landing page) : qu’est-ce c’est ?

Ce qu’on désigne par Page d’atterrissage (ou en anglais Landing Page) correspond à la page sur laquelle l’internaute arrive après avoir cliqué sur un résultat (publicitaire ou naturel) dans les résultats de recherche. Pour garder l’internaute sur son site internet, il importe que la landing page soit pertinente, claire et efficace.

La qualité d’une page d’atterrissage est déterminante à la fois pour les moteurs de recherche et pour les internautes.